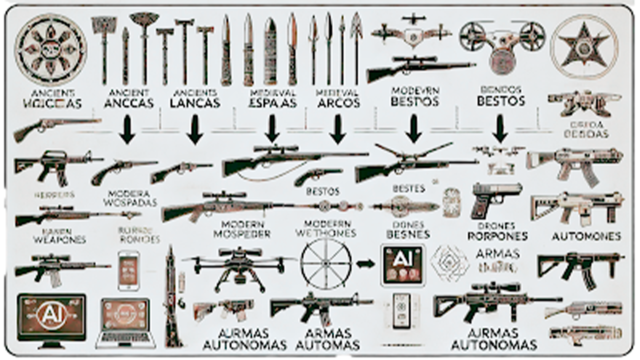

A humanidade se encontra diante de um divisor de águas histórico, marcado pela ascensão vertiginosa da Inteligência Artificial (IA). Essa revolução tecnológica não apenas reconfigura a dinâmica dos conflitos armados, mas também desafia os próprios alicerces do Direito Internacional Humanitário (DIH).

A guerra sempre foi um espelho da humanidade—nossos medos, avanços e limites éticos. No cenário atual, o uso de armas autônomas letais movidas por inteligência artificial desafia as fronteiras do Direito Internacional Humanitário (DIH). Assim como no filme Eu, Robô, onde um androide afirma sentir emoções, as máquinas de guerra modernas não apenas simulam ações humanas, mas tomam decisões sozinhas. Mas quem é responsável quando a máquina erra?

Ao integrar sistemas digitais em áreas como guerra cibernética, armas autônomas e tecnologias espaciais, o mundo moderno expõe os limites éticos e jurídicos de um arcabouço legal forjado em tempos analógicos. A pergunta que emerge, provocativa e urgente, é: estaremos caminhando para um futuro em que o humanismo será subjugado pela frieza de algoritmos e sensores? (Lahmann, 2022)

A guerra, eterna expressão da ambivalência humana, ganha contornos ainda mais sombrios no século XXI. Se antes era o palco em que se revelavam coragem e crueldade, hoje ela reflete a inquietante capacidade humana de criar ferramentas que ampliam o poder destrutivo ao mesmo tempo que desumanizam o ato de guerrear. A IA, ao processar dados massivos e tomar decisões autônomas, insinua-se como a protagonista de uma nova era bélica, com promessas de eficiência e precisão, mas também com o potencial de escalar a violência a níveis jamais vistos.

Nesse contexto, a autonomia crescente das armas impõe uma reflexão crítica. Sistemas de Armas Autônomas Letais (LAWS), como os drones em enxame, abalam os pilares do DIH. A capacidade de uma máquina decidir, de forma independente, quem vive e quem morre representa uma abdicação moral perigosa. Não se trata apenas de uma questão técnica ou jurídica, mas de um profundo dilema ético. A guerra, que outrora demandava decisões humanas impregnadas de empatia e ponderação moral, ameaça se transformar em um processo mecânico, no qual vidas humanas são reduzidas a estatísticas algorítmicas. (Siregar et al., 2024)

As armas autônomas representam um salto tecnológico sem precedentes. Elas podem operar sem intervenção humana direta, executando missões complexas e, muitas vezes, letais. Mas, quando um drone decide disparar, quem é culpado pelo dano causado?

A ausência de controle humano direto nas decisões de combate levanta questões perturbadoras. Quais garantias existem de que um algoritmo será capaz de distinguir combatentes de civis ou avaliar a proporcionalidade do uso da força? Pior ainda, quem será responsabilizado pelas violações do DIH: o programador, o fabricante, o comandante militar ou a própria máquina? Esse “vácuo de responsabilidade” pode abrir precedentes perigosos, tornando a justiça inatingível.

Essa é uma das questões centrais abordadas pelo DIH. Esse ramo do direito é baseado em princípios como distinção, proporcionalidade e necessidade militar. Essas regras visam proteger civis e restringir o uso excessivo da força. O princípio da distinção determina que os ataques devem ser direcionados apenas a combatentes ou estruturas militares, mas será que as máquinas conseguem diferenciar alvos com precisão? Já o princípio da proporcionalidade exige que a força utilizada seja comedida, evitando danos desnecessários. Por fim, o princípio de evitar sofrimento desnecessário determina que mesmo em guerra o sofrimento humano deve ser minimizado.

O uso dessas armas levanta dúvidas sobre a responsabilidade em caso de erros. De acordo com especialistas, comandantes militares poderiam ser responsabilizados por “dolo eventual”, ou seja, por assumirem o risco ao autorizarem o uso dessas armas. No entanto, como responsabilizar alguém por decisões tomadas por máquinas que operam de forma independente? Essa lacuna jurídica precisa ser preenchida. Algumas propostas incluem criar tratados internacionais para limitar ou regulamentar o uso dessas tecnologias. Enquanto isso, é necessário reinterpretar as regras já existentes.

A guerra cibernética, por sua vez, redefine o conceito de campo de batalha, expandindo-o para domínios invisíveis e onipresentes. Ataques a infraestruturas críticas, manipulação de informações e operações de influência digital demonstram como o ciberespaço se tornou uma arena onde se disputam não apenas territórios, mas também consciências. Imagine um cenário em que hospitais perdem acesso a dados vitais, redes elétricas colapsam e instituições financeiras são paralisadas. Esse novo teatro de guerra amplifica a fragilidade das sociedades modernas e exige uma regulamentação internacional robusta para conter os abusos. (Kamel Junior, 2024; Jesus, 2024)

Ademais, a dificuldade de atribuir responsabilidade por ataques cibernéticos exacerba o problema. A anonimidade do ciberespaço incentiva a impunidade e mina os esforços de aplicação do DIH. A criação de normas claras e mecanismos eficazes de atribuição é imperativa para evitar a escalada dessa ameaça.

No domínio da militarização do espaço, o desenvolvimento de armas cinéticas e ciberataques reforça a corrida armamentista global, transformando o que deveria ser um ambiente de cooperação pacífica em mais um palco de rivalidade e destruição. A destruição de satélites e infraestruturas espaciais ameaça serviços essenciais, como comunicações e monitoramento ambiental, colocando em risco a segurança global. (Rosa, 2024)

É fundamental desconstruir a narrativa simplista que enxerga a IA como uma solução mágica para os desafios da guerra. A crença em uma “guerra limpa” é uma falácia perigosa. Embora a IA possa otimizar processos logísticos e estratégicos, seu potencial destrutivo e desumanizador não pode ser ignorado. Em vez de uma promessa de eficiência, a IA carrega a sombra de uma guerra mais letal e descontrolada.

Para lidar com esses desafios, podemos imaginar regulamentações baseadas em diretrizes programáveis de ética, onde as máquinas incorporem princípios humanitários em seus sistemas. Isso exigiria transparência nos algoritmos e certificações que garantam conformidade com o DIH. Também é sugerido um modelo de “responsabilidade compartilhada”, no qual tanto os programadores quanto os comandantes dividiriam a responsabilidade pelos resultados dessas armas.

O avanço das armas autônomas coloca o DIH em xeque. Em um mundo onde as máquinas decidem quem vive e quem morre, a humanidade precisa reafirmar seus valores. O debate não é apenas sobre regulamentar a tecnologia, mas sobre preservar a justiça em tempos de guerra. Refletir sobre as implicações dessas armas é um convite para a sociedade internacional agir antes que a realidade ultrapasse a ficção. Precisamos de normas claras, responsabilização bem definida e, acima de tudo, um compromisso contínuo com os direitos humanos.

O desafio ético-jurídico imposto pela integração da IA nos conflitos armados exige uma resposta internacional firme e coordenada. É imperativo garantir que o controle humano sobre decisões de vida e morte permaneça intacto, ao mesmo tempo que se estabelecem mecanismos de responsabilização claros. Como alerta Kamel Junior (2024), “a IA transforma a guerra, mas não elimina sua essência trágica e desumana”.

Se você quer saber mais sobre o tema, algumas leituras recomendadas incluem o artigo de Rafael Gonçalves Mota, “Direito Internacional Humanitário e as Armas Autônomas” e o livro Wired for War de P. W. Singer. Para quem se interessa por inteligência artificial, vale conferir Inteligência Artificial a Nosso Favor de Stuart Russel e Homo Deus de Yuval Harari. Esses materiais ajudam a entender os desafios e as soluções possíveis para esse cenário tão complexo e urgente.

Referências

____________________

Artificial Intelligence and Related Technologies in Military Decision-Making

ICRC; GENEVA ACADEMY. Artificial intelligence and related technologies in military decision-making on the use of force in armed conflicts: current developments and potential implications. Expert Consultation Report. Genebra: ICRC, mar. 2024. Disponível em: site. Acesso em: 5 jan. 2025

CHEAITO, Karime. De Gaza à Beirute: a névoa da guerra paira para além do Oriente Médio. Orbis: Boletim do LEPEB-UFF, v. 2, n. 6, p. 12-23, maio-ago. 2024. ISSN 2965-2235.

EKELHOF, Merel; PAOLI, Giacomo Persi. The human element in decisions about the use of force. UNIDIR, 2020. Disponível em: https://unidir.org/publication/the-human-element-in-decisions-about-the-use-of-force.

GENEVA ACADEMY; ICRC. Expert consultation report on AI and related technologies in military decision-making. Geneva: ICRC, 2024.

HARARI, Yuval Noah. Homo Deus: Uma breve história do amanhã. São Paulo: Companhia das Letras, 2016.

ICRC. ICRC position on autonomous weapon systems. Genebra: Comitê Internacional da Cruz Vermelha, 2021. Disponível em: https://www.icrc.org/en/document/icrc-position-autonomous-weapon-systems.

JESUS, Everaldo Antônio de. As Convenções de Genebra: Relevância, desafios contemporâneos e a necessidade de adaptação no Direito Internacional Humanitário. Revista do Ministério Público Militar, Brasília, v. 51, n. 43, edição especial, p. 79-116, nov. 2024. DOI: 10.5281/zenodo.13939804. Disponível em: https://doi.org/10.5281/zenodo.13939804. Acesso em: 5 jan. 2025

LAHMANN, Henning. The Future Digital Battlefield and Challenges for Humanitarian Protection: A Primer. Working Papers. abril, 2022. Disponível em: site. Acesso em: 5 jan. 2025

LYE, Harry. IDF acquires Rafael fire weaver sensor-to-shooter system. Army Technology, 2020. Disponível em: https://www.army-technology.com/news/idf-rafael-weaver/.

MAXWELL, Paul. Artificial intelligence is the future of warfare (just not in the way you think). Modern War Institute, 2020. Disponível em: https://mwi.westpoint.edu/artificial-intelligence-future-warfare-just-not-way-think/.

MOTA, Rafael Gonçalves. Direito Internacional Humanitário e as Armas Autônomas. Revista de Direito Internacional, Brasília, v. 19, n. 3, p. 336-354, 2022.

OWNBY, Michael; KOTT, Alexander. Predicting enemy’s actions improves commander decision-making. Arxiv.org, 2016. Disponível em: https://arxiv.org/abs/1607.06759.

ROSA, Carlos Eduardo Valle. Inteligência Artificial e Seleção de Alvos. In: ROSA, Carlos Eduardo Valle (Org.). A Geopolítica Aplicada ao Poder Aeroespacial na Atualidade. Rio de Janeiro: EDUNIFA, 2024. v. 2, cap. 10, p. 74-80.

RUSSEL, Stuart. Inteligência Artificial a Nosso Favor: Como manter o controle sobre a tecnologia. São Paulo: Companhia das Letras, 2021.

SHULTZ, Richard H.; CLARKE, Richard D. Big data at war: special operations forces and Project Maven. Modern War Institute, 2020. Disponível em: https://mwi.westpoint.edu/big-data-at-war-special-operations-forces-project-maven-and-twenty-first-century-warfare/.

SINGER, P. W. Wired for War: The Robotics Revolution and Conflict in the 21st Century. New York: Penguin Books, 2009.

VELJKOVIĆ, Sanela. Possibility of Applying the Rules of International Humanitarian Law to Cyber Warfare. Law – Theory and Practice, n. 3, p. 17–28, 2024. DOI: 10.5937/ptp2403017V. Disponível em: site. Acesso em: 5 jan. 2025

WOLFE, Frank. U.S. collateral damage estimation process could benefit from real-world data. Defense Daily, 2021. Disponível em: https://www.defensedaily.com/u-s-collateral-damage-estimation-process-benefit-real-world-data/weapons/.